Создать копию сайта (RIP) на Linux

Создавать копии сайтам можно не только в корыстных целях, мало ли человеку понадобилось иметь копию сайта для себя. Например полистать онлайн библиотеку не имея интернета. Сохраняем себе на диск копию сайта когда интернет есть и листаем себе в удовольствие.

Метод который я покажу ниже будет работать только в операционных системах семейство Linux. У меня на ноутбуке Ubuntu 12.04 на нем и покажу как при помощи стандартной утилиты WGET сделать зеркало сайта.

Данный метод может пригодится и копипастерам в создании сетки сателитов на ворованном тексте, но помните, что такие сайты долго не живут и будут просто тратой времени и нервов.

Сперва давайте создадим папку где будут сохранятся наши сайты.

cd /home/user/ mkdir web-sitesМы создали папку web-sites в директорию нашего пользователя. Публичные права тут не нужны, достаточно просто наличие папки.

Создать быстро копию сайта

Если на сайте нет ограничение во времени на интервалы между запросами к страницам сайта, то можно использовать сразу команду:wget -mk http://exemple.ruПосле выполнения данной команды в папке web-sites создастся папка с названием сайта которого мы хотели копировать. Иерархия каталогов сайта сохранится идентично. На вашем компьютере сохранится картинки, css, js, swf файлы и т.д.

Если же на сайте присутствует ограничение запросов, то можно добавить ограничение во времени.

wget -mk -w 30 http://exemple.ruВ данном случае интервал перехода между страницами будет в 30 секунд.

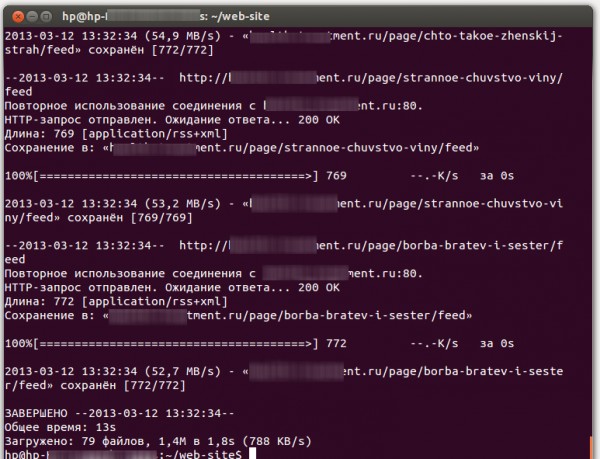

Вот как выглядит завершение копирование сайта у меня в терминале:

Уже нет необходимости искать платные / бесплатные программы чтобы сделать рип сайту, достаточно знать некоторые особенности утилит в Linux. Для более подробной инструкции напишите в терминале man wget

1) Какие способы копирования сайта знаете вы?

2) Почему вам понадобилось копировать какой либо сайт?